난 AI분야를 전공했거나 Computer Science를 공부하진 않았지만 대학에서 Mechanical Engineering을 배웠고 그 지식을 이용해서 삶을 살아가고 있는 평범한 공학 엔지니어이다.

요즘 시대는 AI를 몰라서도 안되고 사용할 줄 모르면 안되는 AI가 보편적인 세상으로 점점 변해가고 있다.

아직은 나도 내 주업무를 해나가는데 직접적으로 AI를 많이 사용하고 있지 않지만 어느 순간부터는 AI를 매우 잘 다뤄야 하고 매일, 매시간을 같이 일하게 될지도 모를 일이다. 그래서 적을 알고자(?) 비록 전공자는 아니지만 AI가 어떤 것인지는 이해하고자 최근 전세계적으로 큰 관심을 받고 있는 DeepSeek 논문 2편을 읽고 내 나름대로 요약해 보았다. DeepSeek 논문이 AI의 생김새를 꽤 세부적으로 그려놓은 글이라 AI를 포괄적으로 이해하는데 가장 적합한 글이 아닐까 생각한다.

그리고 비전공자가 한 단계 정도는 필터링해서 쓴 글이라 일반인들도 논문을 이해하는대 좀더 쉽지 않을까 생각된다.

(내가 AI분야에서 그나마 자신있게 잘 한다고 생각하는 부분은 Prompt Engineering은 좀 다룰 줄 안다는 거)

1. 서론 : DeepSeek-V3, 오픈소스 거대모델의 새로운 지평을 열다

○ DeepSeek-V3라는 새로운 대규모 언어모델(LLM)을 소개

○ 이 모델은 무려 6710억 개의 파라미터를 가지고 있으며, 그 중 370억 개가 각 토큰처리시 활성화되는 MoE (Mixture-of-Experts, 전문가 혼합) 구조를 채택. 이는 여러 명의 전문가가 협력하여 문제를 해결하는 것처럼, 모델 내부적으로 다양한 전문성을 가진 하위모델(전문가)들을 활용하여 더욱 효율적이고 강력한 성능을 내는 방식임

○ 핵심 메시지

ㆍ DeepSeek-V3는 "더 크고, 더 효율적이고, 더 강력한 오픈소스 모델"을 목표로 개발되었고, 효율성에 집중하여, 고성능을 유지하면서도 학습 및 추론 비용을 절감하는데 많이 노력하였음

○ 논문이 던지는 질문

ㆍ 오픈소스 모델도 최고 수준의 성능을 낼 수 있을까?

⇒ DeepSeek-V3는 폐쇄형 모델(GPT-4, Claude 등)과의 격차를 줄이고, 일부영역에서는 이를 능가하였음

ㆍ 거대모델학습의 효율성을 극대화할 수 있을까?

⇒ DeepSeek-V3는 새로운 기술들을 통해 학습비용을 획기적으로 줄임

ㆍ MoE 구조를 더욱 효과적으로 활용할 수 있을까?

⇒ DeepSeek-V3는 MoE 구조의 장점을 극대화하기 위한 새로운 전략들을 제시

2. DeepSeek-V3의 핵심 기술과 혁신

- DeepSeek-V3 논문은 크게 모델구조, 학습 인프라, 성능평가 세 부분으로 나눌 수 있음. 각 부분에서의 주목할만한 핵심기술과 혁신들은 다음과 같음

2.1. 모델 구조 (Architecture)

(1) Multi-head Latent Attention (MLA): 효율적인 추론을 위한 핵심기술

○ 기존 Transformer 모델에서는 Multi-Head Attention (MHA)을 사용하는데 Key-Value (KV) 캐시를 저장하는데 많은 메모리를 사용. 이는 긴 문맥을 처리하거나 많은 사용자를 동시에 처리할 때 병목 현상을 일으킬 수 있음

○ DeepSeek-V3는 MLA라는 새로운 attention 메커니즘을 도입하여 KV 캐시 크기를 획기적으로 줄임.

○ MLA는 attention 계산시 사용하는 Key와 Value를 저차원으로 압축하여 저장하고, 필요할 때 다시 고차원으로 복원하는 방식을 사용함

ㆍ 중요한 정보를 요약해서 메모해두고, 필요할 때 자세한 내용을 빠르게 떠올리는 것과 같음. 메모리 사용량을 줄이면서도 정보손실을 최소화하여 효율적인 추론이 가능하게 함

(2) DeepSeekMoE with Auxiliary-Loss-Free Load Balancing: MoE 구조의 효율성과 성능 극대화

○ DeepSeek-V3는 MoE 구조를 채택하여 모델 용량을 키우면서도 효율적인 학습 및 추론을 가능하게 함. 하지만 MoE 구조는 전문가(expert)들의 로드 밸런싱 문제가 발생할 수 있음. 특정 전문가에게만 과도하게 부하가 걸리면 학습 효율성이 떨어지고 성능 저하를 야기할 수 있음

ㆍ MoE (Mixture-of-Experts, 전문가 혼합) 구조

○ MoE는 마치 여러 명의 전문가를 둔 것과 같은 구조. 질문이 들어오면, 모델은 그 질문에 가장 적합한 전문가 몇 명(DeepSeek-V3의 경우 370억 개 파라미터)만 활성화시켜 답변을 생성. 이는 모든 파라미터를 다 사용하는 것보다 훨씬 효율적이며, 더 적은 계산량으로 더 빠르게 답변할 수 있게 해줌 6710억 개의 파라미터는 엄청난 규모이지만, 실제로 답변 생성에 사용되는 파라미터는 370억 개로 줄어들어 효율적인 추론이 가능함

ㆍ 기존 MoE 모델들은 보조 손실(auxiliary loss)을 사용하여 로드 밸런싱을 유도했지만, 이는 모델성능을 저하시킬 수 있다는 단점이 있었음

ㆍ DeepSeek-V3는 보조손실 없는 로드 밸런싱 전략을 새롭게 제시함. 각 전문가에게 편향(bias)항을 도입하여, 학습과정에서 전문가들의 부하를 실시간으로 모니터링하고 편향(bias)항을 동적으로 조절하여 로드 밸런싱을 달성함

=> 여러 전문가에게 업무를 분배할 때, 각 전문가의 업무량을 균등하게 조절하여 효율성을 높이는 것과 같음. 보조손실이라는 불필요한 간섭 없이, 순수하게 로드 밸런싱만 조절하여 성능저하없이 효율성을 높임

(3) Multi-Token Prediction (MTP): 학습 효율성과 성능 향상을 위한 새로운 학습 목표

○ 일반적으로 언어모델은 다음 토큰 하나만 예측하도록 학습. DeepSeek-V3는 MTP라는 새로운 학습목표를 도입하여, 한 번에 여러 개의 미래 토큰을 예측하도록 학습함.

○ MTP는 학습신호를 풍부하게 만들고, 모델이 미래를 예측하는 능력을 향상시켜 전반적인 성능향상에 기여함. 또한, 추론속도 향상을 위한 speculative decoding에도 활용될 수 있음

ㆍ 다음 단어 하나만 맞추는 게임에서, 다음 몇 개의 단어를 한꺼번에 맞추는 게임으로 바뀐 것과 같음더 많은 것을 예측하도록 학습시키면 모델이 더 똑똑해지고, 추론속도도 빨라질 수 있음

2.2. 학습 인프라 (Infrastructures)

- DeepSeek-V3는 효율적인 학습을 위해 하드웨어와 소프트웨어를 통합적으로 최적화하였음

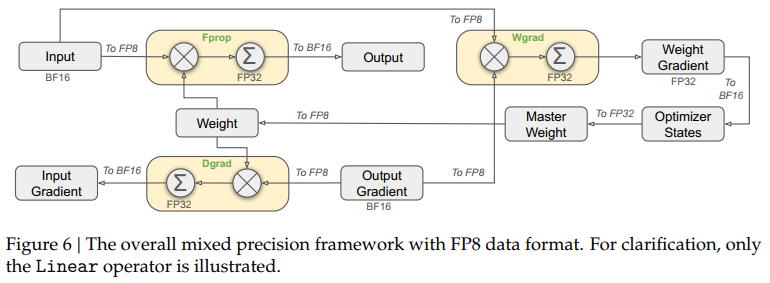

(1) FP8 Mixed Precision Training: 저정밀도 연산으로 학습 속도와 메모리 효율성 극대화

○ FP8 (8-bit Floating Point)는 기존의 FP32 (32-bit Floating Point)나 BF16 (16-bit Floating Point)보다 더 낮은 정밀도의 부동소수점 형식. FP8을 사용하면 메모리 사용량을 줄이고 연산속도를 높일 수 있지만, 정밀도 손실로 인해 학습이 불안정해질 수 있음

○ DeepSeek-V3는 FP8 혼합 정밀도 학습 프레임워크를 개발하여, 대부분의 연산을 FP8으로 수행하면서도, 정밀도가 중요한 일부 연산은 높은 정밀도로 유지하여 학습 안정성을 확보하였음. 특히, 미세 조정된 양자화 전략을 통해 FP8의 동적 범위를 효과적으로 확장하고, CUDA 코어 활용을 통해 연산 정밀도를 높였음

ㆍ 그림을 그릴 때, 넓은 영역은 굵은 붓으로 빠르게 칠하고, 섬세한 부분은 가는 붓으로 정밀하게 칠하는 것과 같음. FP8이라는 굵은 붓으로 학습 속도를 높이고, 정밀도가 필요한 부분은 높은 정밀도로 유지하여 학습 안정성과 효율성을 모두 확보함

(2) DualPipe: 효율적인 파이프라인 병렬 처리

○ 거대모델학습에는 많은 GPU 자원이 필요하며, 파이프라인 병렬 처리 (Pipeline Parallelism, PP)는 모델을 여러 GPU에 분산시켜 학습하는 기술임. 하지만 기존 PP 방식은 파이프라인 거품(pipeline bubble)이라는 비효율적인 구간이 발생하여 GPU 활용률을 떨어뜨렸음.

○ DeepSeek-V3는 DualPipe라는 새로운 PP 알고리즘을 개발하여 파이프라인 거품을 최소화하고, 계산과 통신을 겹쳐서 수행하여 GPU 활용률을 극대화하였음. 특히, MoE 구조에서 발생하는 노드 간 통신 병목현상을 효과적으로 해결함

ㆍ 공장에서 생산라인을 효율적으로 설계하여, 작업이 끊김없이 이어지도록 하는 것과 같음. DualPipe는 GPU들이 쉬지 않고 계속해서 계산하도록 만들어 학습속도를 높임

(3) 기타 인프라 최적화

ㆍ 교차노드간 All-to-All 통신 최적화: InfiniBand 및 NVLink 대역폭을 최대한 활용하여 통신 효율성을 높임

ㆍ 메모리 사용량 최적화: RMSNorm 및 MLA Up-Projection 재계산, EMA (Exponential Moving Average) CPU 저장, MTP 모듈의 Embedding 및 Output Head 공유 등 다양한 기술을 통해 메모리 사용량을 획기적으로 줄였음

3. 성능 평가 (Evaluations)

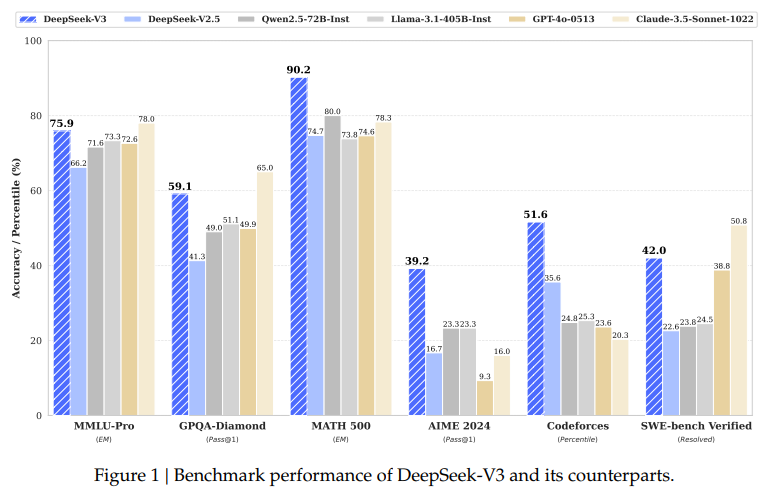

※ DeepSeek-V3는 다양한 벤치마크에서 뛰어난 성능을 입증하였음

(1) 지식 능력

○ MMLU, MMLU-Pro, GPQA 등 교육 벤치마크에서 오픈소스 모델 중 최고 성능을 달성했으며, GPT-4, Claude-3.5 Sonnet 등 최고 수준의 폐쇄형 모델과 견줄 만한 성능을 보임. 특히, 중국어 관련 지식 벤치마크에서 강점을 나타냄

(2) 코드/수학/추론 능력

○ MATH-500 등 수학 벤치마크에서 최고 수준의 성능을 기록, LiveCodeBench 등 코딩 벤치마크에서도 최고 성능 모델임을 확인함. 특히, 수학추론능력에서 뛰어난 성능을 보였음

(3) 긴 문맥 처리 능력

○ "Needle In A Haystack" (NIAH) 테스트에서 128K 길이의 긴 문맥에서도 뛰어난 정보검색능력을 보여주며, 긴 문맥 처리 능력 또한 입증함

(4) 오픈 엔드 질문 답변 평가

○ Arena-Hard, AlpacaEval 2.0 등 인간평가 기반 벤치마크에서도 최고 수준의 성능을 기록, 실제 사용환경에서의 성능 또한 뛰어남을 보여주었음

※ DeepSeek-V3는 오픈소스 모델 중 가장 강력한 모델이며, 코드 및 수학 분야에서 특히 뛰어난 성능을 보임. 또한, 폐쇄형 모델과 견줄 만한 성능을 달성하며 오픈소스 LLM의 새로운 가능성을 제시하였음

4. 학습비용 및 효율성

○ DeepSeek-V3의 가장 큰 장점 중 하나는 뛰어난 효율성임

(1) 학습비용 절감: DeepSeek-V3 전체 학습에 278만 H800 GPU 시간만 소요. 이는 경쟁모델대비 매우 경제적인 비용

(2) 학습 안정성: 학습과정에서 loss spikes나 rollback 없이 안정적으로 학습이 진행되었음

(3) 토큰당 학습비용 절감: 1조 토큰당 학습비용이 18만 H800 GPU 시간으로 매우 효율적이었음

※ DeepSeek-V3는 경제적인 비용측면에서 최고 수준의 성능을 달성했으며, 이는 효율적인 모델구조와 학습 인프라를 가졌음을 의미함

5. 결론 및 향후 방향

○ DeepSeek-V3는 혁신적인 기술들을 통해 효율성, 성능, 경제성을 모두 갖춘 강력한 오픈소스 LLM. 특히, MLA, DeepSeekMoE, 보조손실 없는 로드 밸런싱, MTP, FP8 혼합 정밀도 학습, DualPipe 등 다양한 기술적 혁신이 돋보였음

6. 논문에서 제시하는 한계점 및 향후 방향

○ 배포(Deployment) 측면의 한계

ㆍ DeepSeek-V3는 효율적인 추론을 위해 비교적 큰 배포 단위가 필요하며, 소규모 팀에게는 부담이 될 수 있음

○ 지속적인 모델 구조 개선 및 확장

ㆍ Transformer 구조의 한계를 극복하고, 무한 문맥 길이 지원을 위한 연구를 지속할 계획임

○ 데이터 품질 및 양 증대

ㆍ 학습데이터의 양과 질을 지속적으로 개선하고, 다양한 학습 신호원을 탐색하여 데이터 스케일링을 확장할 예정

○ 심층 사고능력 강화

ㆍ 모델의 지능과 문제 해결 능력을 향상시키기 위해 추론 길이와 깊이를 확장하는 연구를 지속할 것임

○ 다차원적인 모델평가 방법개발

ㆍ 벤치마크 편향을 방지하고 모델의 실제 능력을 정확하게 평가하기 위한 연구를 지속할 것임

7. 전반적인 중요성 및 시사점

○ 오픈소스 LLM 생태계 발전 기여

ㆍ DeepSeek-V3는 오픈소스 LLM 분야의 기술수준을 한 단계 끌어올렸으며, 연구개발에 대한 귀중한 자원을 제공함

○ 거대 모델 학습의 효율성 증대

ㆍ DeepSeek-V3의 효율적인 학습기술들은 향후 거대모델 연구개발에 중요한 참고사례가 될 것임

○ AI 기술 보편화에 기여

ㆍ DeepSeek-V3와 같은 고성능 오픈소스 모델의 등장은 AI 기술에 대한 접근성을 보다 높일 수 있는 계기가 되었음

■ 참조 - 용어 정리

1. Shot

ㆍ AI 테스트에서 하나의 입력과 그에 대한 모델의 출력을 의미하는 기본적인 테스트 단위

2. Pile-test (BPB - Bits Per Byte)

ㆍ Pile (더미) > 방대한 양의 텍스트 데이터셋. 웹사이트, 책, 논문, 코드 등 다양한 종류의 텍스트 데이터를 포함

ㆍ Pile-test > Pile 데이터셋의 일부를 사용하여 언어모델의 성능을 평가하는 벤치마크. 주로 다음 단어예측 (Next Word Prediction) 능력을 측정

ㆍ BPB (Bits Per Byte) > 평가지표로, 낮을수록 모델의 성능이 좋음. BPB는 모델이 데이터를 얼마나 효율적으로 압축하는지를 나타냄. 낮은 BPB는 모델이 텍스트 데이터의 패턴을 더 잘 학습하고, 다음 단어를 더 정확하게 예측할 수 있다는 것을 의미

ㆍ Pile-test는 언어 모델이 얼마나 일반적인 텍스트 데이터를 잘 이해하고 생성할 수 있는지를 평가

3. BBH (EM - Exact Match)

ㆍ Big Bench Hard (BBH) > Google에서 개발한 어렵고 복잡한 질문들로 구성된 벤치마크. 상식 추론, 수학 문제, 코딩 문제, 윤리적 딜레마 등 다양한 유형의 어려운 질문들을 포함

ㆍ EM (Exact Match) > 평가 지표로, 모델이 제시한 답변이 정답과 정확히 일치해야만 점수를 얻음

ㆍ 의미 > BBH는 언어 모델이 고차원적인 추론 능력, 복잡한 문제 해결 능력, 그리고 다양한 분야에 대한 지식을 얼마나 잘 갖추고 있는지를 평가하는데 사용. 기존 벤치마크보다 훨씬 어려운 문제들을 포함하여, 모델의 진정한 지능을 측정

4. MMLU (EM - Exact Match)

ㆍ Massive Multitask Language Understanding (MMLU) > 다양한 분야의 객관식 질문으로 구성된 벤치마크. 인문학, 사회과학, 자연과학, 공학 등 57개의 다양한 분야를 포괄

ㆍ EM (Exact Match) > 모델이 선택한 객관식 답변이 정답과 정확히 일치해야만 점수를 얻음

ㆍ MMLU는 언어 모델이 광범위한 지식을 얼마나 잘 습득하고 활용할 수 있는지를 평가하는데 사용. 다양한 분야의 질문을 통해 모델의 종합적인 이해능력을 측정

5. DROP (F1 - F1 Score)

ㆍ Discrete Reasoning Over Paragraphs (DROP) > 독해 및 추론 능력을 평가하는 벤치마크. 짧은 단락 (Paragraph) 과 관련된 질문에 대해, 모델은 단락 내에서 정보를 추출하고 추론하여 답변. 특히 수치 추론, 날짜 추론, 비교 추론 등 복잡한 추론 능력을 요구

ㆍ F1 (F1 Score) > 정밀도 (Precision) 와 재현율 (Recall) 의 조화평균. 정답과 모델의 예측이 부분적으로 일치하는 경우에도 점수를 얻을 수 있음. 독해 및 추론 벤치마크에 주로 사용되는 지표.

ㆍ DROP은 언어 모델이 텍스트를 이해하고, 필요한 정보를 찾고, 논리적인 추론을 수행하여 질문에 답변할 수 있는지를 평가하는데 사용

6. TriviaQA (EM - Exact Match)

ㆍ Trivia Question Answering (TriviaQA) > 상식 및 퀴즈 형태의 질문 답변 벤치마크. 인터넷에서 수집된 다양한 퀴즈 질문과 정답으로 구성

ㆍ EM (Exact Match) > 평가 지표로, 모델이 제시한 답변이 정답과 정확히 일치해야만 점수를 얻음

ㆍ TriviaQA는 언어 모델이 방대한 상식 지식을 얼마나 잘 저장하고 활용하여 질문에 답변할 수 있는지를 평가하는데 사용

7. NaturalQuestions (EM - Exact Match)

ㆍ Natural Questions (NaturalQuestions) > Google 검색 쿼리에서 추출한 실제 사용자들이 검색하는 질문으로 구성된 벤치마크. 질문과 함께 위키백과 페이지가 제공되며, 모델은 위키백과에서 질문에 대한 답변을 찾아야 함

ㆍ EM (Exact Match) > 모델이 제시한 답변이 정답과 정확히 일치해야만 점수를 얻음

ㆍ NaturalQuestions는 언어 모델이 실제 사용자들이 궁금해하는 질문에 대해, 관련 문서를 분석하여 정확한 답변을 찾아낼 수 있는 능력을 평가하는데 사용. 정보 검색 및 독해 능력을 종합적으로 평가.

8. HumanEval (pass@1)

ㆍ HumanEval > 코드생성능력을 평가하는 벤치마크. 자연어 설명으로 주어진 프로그래밍 문제에 대해, 모델은 Python 코드를 생성해야 함. 모델이 생성한 코드는 자동으로 테스트 케이스를 통과하는지 여부를 평가받음.

ㆍ pass@1 (Pass at 1) > 모델이 단 한 번 생성한 코드가 모든 테스트 케이스를 통과하면 성공으로 간주. pass@k (k번 시도 중 한 번이라도 성공하면 성공)와 같은 다양한 변형이 있음

ㆍ HumanEval은 언어 모델이 자연어 설명을 이해하고, 이를 기반으로 정확하고 실행 가능한 코드를 생성할 수 있는지를 평가하는데 사용

9. MBPP (pass@1)

ㆍ Mostly Basic Python Programming (MBPP) > HumanEval과 마찬가지로 코드 생성 능력을 평가하는 벤치마크. HumanEval보다 상대적으로 쉬운 Python 프로그래밍 문제들로 구성되어 있음

ㆍ pass@1 (Pass at 1) > 평가 지표는 HumanEval과 동일하게 pass@1을 사용

ㆍ MBPP는 언어모델의 기본적인 코딩능력을 평가하는데 사용. HumanEval에 비해 쉬운 문제들을 통해 모델의 초기 코딩능력 발전을 측정하는데 유용

10. GSM8K (EM - Exact Match)

ㆍ Grade School Math 8K (GSM8K) > 초등학교 수준의 수학단어문제로 구성된 벤치마크. 덧셈, 뺄셈, 곱셈, 나눗셈 등 기본적인 수학 연산을 포함하는 문제들을 모델이 풀어야 함

ㆍ EM (Exact Match) > 모델이 계산한 숫자 답변이 정답과 정확히 일치해야만 점수를 얻음

ㆍ GSM8K는 언어모델이 수학적인 추론 능력, 특히 단어문제를 이해하고, 필요한 계산과정을 수행하고, 정확한 답을 도출할 수 있는지를 평가하는데 사용

11. MATH (EM - Exact Match)

ㆍ MATH > 고등학교 및 대학 1학년 수준의 어려운 수학문제로 구성된 벤치마크. 대수, 기하, 미적분, 확률, 통계 등 다양한 분야의 수학 문제들을 포함

ㆍ EM (Exact Match) > 평가 지표는 GSM8K와 동일하게 Exact Match를 사용

ㆍ MATH는 언어모델의 고급수학문제 해결능력을 평가하는데 사용. GSM8K보다 훨씬 어려운 문제들을 통해 모델의 수학적 추론능력의 한계를 측정.

※ 요약

- Pile-test, BBH, MMLU, DROP, TriviaQA, NaturalQuestions > 언어모델의 다양한 능력을 평가하는 벤치마크 (언어이해, 추론, 지식, 독해 등)

- HumanEval, MBPP > 코드 생성 모델의 성능을 평가하는 벤치마크

- GSM8K, MATH > 수학 문제 해결 능력을 평가하는 벤치마크

12. MMLU (Massive Multitask Language Understanding)

ㆍ 다양한 주제에 대한 지식과 추론능력을 평가하는 벤치마크. STEM(과학, 기술, 공학, 수학), 인문학, 사회과학 등 다양한 분야의 15,000개 이상의 객관식 문제로 구성

ㆍ pass@1 > 모델이 문제들을 한 번의 시도 만에 풀 수 있다는 의미

13. MMLU-Redux

ㆍ MMLU 데이터셋의 개선버전으로 추측. Redux라는 용어는 일반적으로 기존 데이터셋의 오류를 수정하거나, 난이도를 조절하거나, 평가방식을 변경하는 등 개선작업을 거친 버전을 의미

ㆍ EM (Exact Match) > 예측한 답변이 정답과 정확히 일치하는 경우에만 정답으로 간주하는 평가방법. 오탈자도 확인함

14. MMLU-Pro

ㆍ MMLU 데이터셋의 더욱 전문가 버전으로 추측함

ㆍ EM (Exact Match) > 예측한 답변이 정답과 정확히 일치해야 정답으로 인정

15. IF-Eval (Instruction Following Evaluation)

ㆍ 모델이 주어진 명령어를 얼마나 정확하게 따르는지를 평가하는 벤치마크

ㆍ 모델이 사용자의 의도를 정확하게 파악하고, 그에 맞는 결과물을 생성할 수 있는지 평가

ㆍ Prompt Strict > 모델이 명령어에 매우 엄격하게 따라야 함을 의미. 명령어를 약간이라도 벗어나면 오답으로 처리. 창의적인 답변보다는 정확한 명령어 수행능력을 평가함

16. GPQA Diamond (Google-Problem QA Diamond)

ㆍ GPQA > Google-Problem QA 의 약자. 매우 어려운 질문-답변 데이터셋으로, 전문적인 수준의 지식과 추론 능력을 요구

ㆍ Diamond Bench > 정확한 의미는 확인할 수 없으나 GPQA 데이터셋의 특정난이도 수준 또는 필터링된 하위 집합을 의미할 것으로 추측됨

ㆍ pass@1 > 모델이 문제들을 한 번의 시도 만에 풀 수 있다는 의미

17. SimpleQA (Simple Question Answering)

ㆍ 간단한 질문에 대한 답변을 요구하는 데이터셋. 모델의 기본적인 질의응답 능력을 평가

ㆍ 모델이 간단한 질문을 이해하고, 관련정보를 검색하여 정확한 답변을 생성할 수 있는지 평가함

ㆍ Correct > 모델이 정답을 맞춘 비율을 의미함

18. FRAMES

ㆍ 대화형 사용자 인터페이스(UI)를 시뮬레이션하는 작업에 사용될 수 있는 데이터셋. 대화의 흐름을 이해하고, 그에 따라 적절한 UI 액션을 보이는지 예측하는 능력을 평가함

ㆍ Acc. (Accuracy) > 모델이 올바른 UI 액션을 예측한 비율을 나타냄

19. LongBench v2 (Long Range Benchmark version)

ㆍ 다양한 유형의 긴 문서 (뉴스 기사, 소설, 회의록, 법률 문서 등) 에 대한 모델의 long-context 이해능력을 종합적으로 평가하는 벤치마크

ㆍ Acc. (Accuracy) > 모델이 생성한 답변이 정답으로 인정되는 비율을 측정

20. HumanEval-Mul

ㆍ HumanEval-Mul > 코드 생성 벤치마크 HumanEval 을 확장하여 8개의 프로그래밍 언어 (Python, Java, C++, C#, JavaScript, TypeScript, PHP, Bash) 에 대한 코드 생성 능력을 평가

ㆍ pass@1 > 모델이 문제들을 한 번의 시도 만에 풀 수 있다는 의미

21. LiveCode Bench

ㆍ LiveCode > 실시간 코딩 챌린지를 의미. 모델이 즉석에서 코드를 작성하고 실행하여 문제를 해결하는 능력을 평가

ㆍ Bench > AI 모델의 실시간 코딩 능력을 평가하기 위해 특별히 설계된 벤치마크지수로 추측됨

ㆍ pass@1 > 모델이 LiveCode 챌린지를 한 번의 시도 만에 성공적으로 완료했다는 의미

22. CodeForces

ㆍ CodeForces > 온라인 코딩 콘테스트 플랫폼. 사용자는 코딩문제를 풀고, 그 결과에 따라 Rating이 매겨짐. Rating이 높을수록 코딩 실력이 뛰어남을 의미

23. SWE Verified (Software Engineering Verified)

ㆍ 소프트웨어 엔지니어링과 관련된 특정문제를 해결하는 능력을 평가하는데 사용

ㆍ Resolved > 모델이 해결한 문제의 수를 나타냄

24. Aider-Polyglot

ㆍ 코딩작업을 자동화하는 도구로 추측함. Polyglot은 다양한 프로그래밍 언어를 지원한다는 의미

ㆍ Acc. (Accuracy) > Aider-Polyglot이 코딩작업을 정확하게 수행한 비율을 나타냄

25. Aider-Edit

ㆍ Aider-Edit > Aider라는 코딩 보조도구를 사용하여 코드편집 task를 수행하는 모델의 능력을 평가하는 벤치마크. 모델이 기존코드를 이해하고, 주어진 instruction에 따라 코드를 수정하는 능력을 평가함

ㆍ Acc. (Accuracy) > 모델이 코드편집 task를 정확하게 수행한 비율을 측정

26. CNMO 2024 (Chinese National Mathematics Olympiad 2024)

ㆍ 중국 수학 올림피아드 문제

ㆍ pass@1 > 모델이 CNMO 2024 문제를 한 번의 시도로 정답으로 풀 확률을 의미

27. CLUEWSC (Chinese Language Understanding Evaluation Benchmark - Word Sense Classification)

ㆍ 중국어 언어 이해능력을 평가하는 벤치마크의 일부. 문맥에 따라 단어의 의미를 정확하게 파악하는 능력을 평가

ㆍ EM (Exact Match) > 예측한 답변이 정답과 정확히 일치하는 경우에만 정답으로 간주

28. C-Eval (Chinese Evaluation Benchmark)

ㆍ 중국어에 특화된 다양한 자연어 이해 및 생성능력을 평가하는 벤치마크

ㆍ EM (Exact Match) > 예측한 답변이 정답과 정확히 일치하는 경우에만 정답으로 간주

29. C-SimpleQA (Chinese Simple Question Answering)

ㆍ 중국어로 된 간단한 질문에 대한 답변을 요구하는 데이터셋. 중국어 기반의 기본적인 질의응답능력을 평가

ㆍ Correct > 모델이 정답을 맞춘 비율을 나타냄

원문링크: DeepSeek-V3 Technical Report (https://arxiv.org/html/2412.19437v1#S3)

끝. R00.

'Ordinary Life...' 카테고리의 다른 글

| Mechanical Engineer가 비전공자 관점에서 읽어 본 DeepSeek-R1 Paper Review - 02 (1) | 2025.03.07 |

|---|