난 AI분야를 전공했거나 Computer Science를 공부하진 않았지만 대학에서 Mechanical Engineering을 배웠고 그 지식을 이용해서 삶을 살아가고 있는 평범한 공학 엔지니어이다.

"Mechanical Engineer가 비전공자 관점에서 읽어 본 DeepSeek-V3 Paper Review - 01"에 이은 두 번째 DeepSeek 논문 리뷰글이다.

1. 서론: 왜 강화학습으로 추론능력을 키우는가?

○ 최근 대규모 언어모델(LLM)은 급속한 발전을 거듭하며 인간수준의 지능에 점점 더 가까워지고 있음

○ 특히, 사후학습(Post-training)은 LLM의 성능을 더욱 끌어올리는 중요한 단계로 주목받고 있음. 사후학습은 모델이 사회적 가치에 부합하고 사용자의 선호도에 맞게 조정될 수 있도록 돕고, 특히 추론능력을 향상시키는데 효과적임

○ 핵심질문

ㆍ 강화학습만으로 LLM의 추론 능력을 키울 수 있을까?

⇒ 기존 연구들은 주로 지도학습(Supervised Learning, SL) 데이터에 의존했지만, DeepSeek-R1은 순수 강화학습만으로 추론능력을 키우는 새로운 접근 방식을 시도함

ㆍ 어떻게 하면 강화학습을 통해 LLM이 스스로 추론능력을 발전시킬 수 있을까?

⇒ DeepSeek-R1은 자기진화(Self-evolution)라는 개념을 통해 이 질문에 대답함

ㆍ 더 작은 모델에도 강화학습으로 얻은 추론능력을 이전할 수 있을까?

⇒ DeepSeek-R1은 지식 증류(Distillation)를 통해 거대모델의 추론능력을 작은 모델로 이전하는 방법을 탐구함

2. DeepSeek-R1의 핵심 아이디어: 순수 강화학습과 자기진화

- DeepSeek-R1 논문의 핵심은 DeepSeek-R1-Zero와 DeepSeek-R1 두 가지 모델을 통해 순수 강화학습과 콜드 스타트(Cold Start) 데이터를 활용한 강화학습의 효과를 입증하는 것임

2.1. DeepSeek-R1-Zero: 지도학습없이 강화학습만으로 추론능력 획득

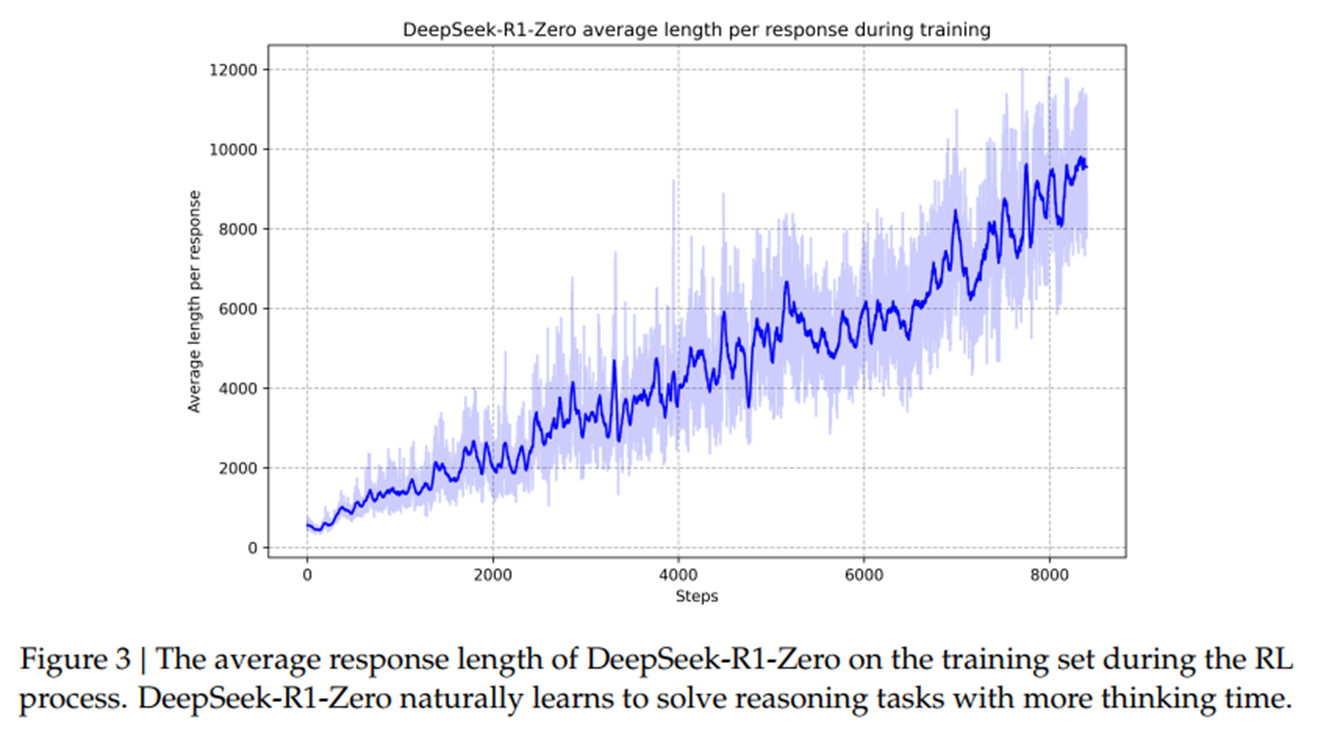

- DeepSeek-R1-Zero는 사전학습된 기반모델(DeepSeek-V3-Base)에 지도학습(SFT)없이 바로 강화학습(RL)을 적용한 모델임. 이는 기존 연구와 달리, 순수 강화학습만으로도 LLM이 복잡한 추론능력을 스스로 학습할 수 있음을 보여주는 획기적인 시도임

(1) 강화학습 알고리즘

○ DeepSeek-R1-Zero는 GRPO (Group Relative Policy Optimization) 알고리즘을 사용. GRPO는 정책모델과 크리틱 모델을 별도로 사용하는 대신, 그룹 스코어를 기반으로 베이스라인을 추정하여 강화학습의 학습비용을 절감하는 방식임

(2) 보상모델

○ DeepSeek-R1-Zero는 규칙기반 보상모델을 사용. 이는 정답여부를 명확하게 판단할 수 있는 수학문제나 코딩문제 등에서 효과적. 모델이 생성한 답변의 정확도와 형식(think/answer 태그 사용 여부)을 평가하여 보상을 제공함

(3) 학습 템플릿

○ DeepSeek-R1-Zero는 "사용자 질문 - (think) 추론 과정 (/think) - (answer) 최종 답변 (/answer)" 형태의 템플릿을 사용. 이는 모델이 추론과정을 명시적으로 생성하도록 유도하고, 강화학습과정에서 모델이 스스로 추론 능력을 발전시켜 나가는 과정을 관찰하기 위함임

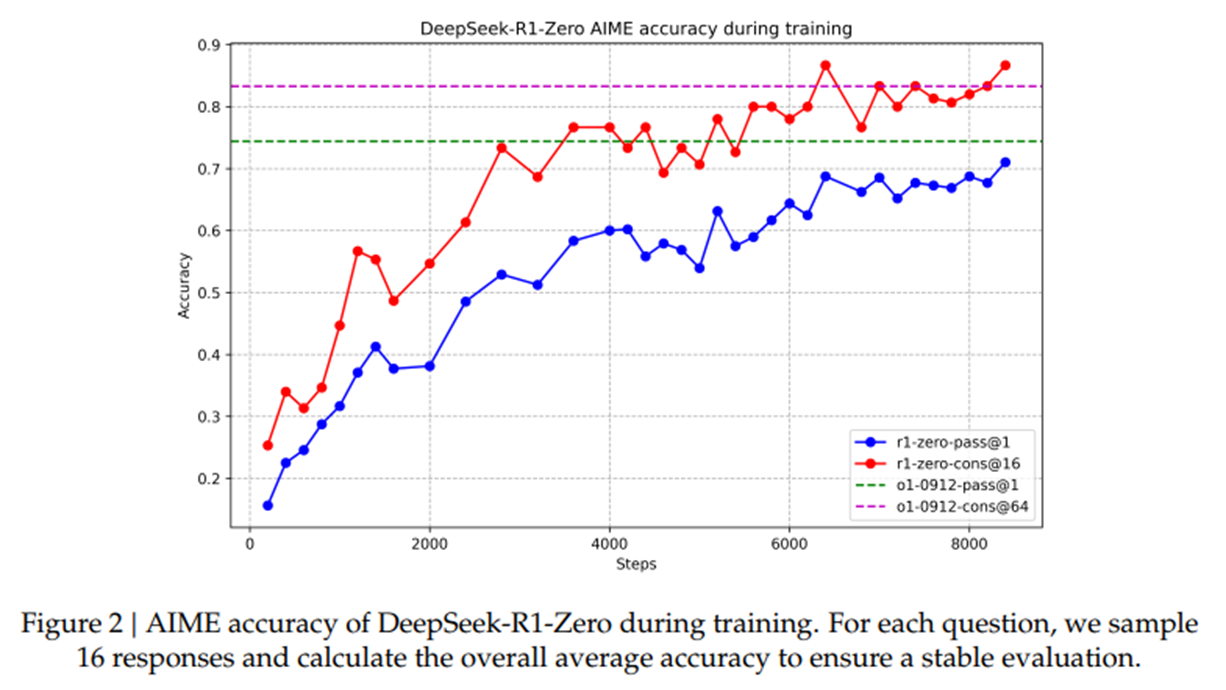

(4) DeepSeek-R1-Zero의 놀라운 성과

○ AIME 2024 벤치마크에서 71.0% pass@1, Majority Voting 시 86.7% 라는 높은 점수를 기록, OpenAI-01-0912 모델과 견줄만한 추론능력을 입증함

※ 강화학습 과정에서 자기검증(Self-verification), 반성(Reflection), 긴 CoT 생성 등 정교한 추론 행동이 자연스럽게 나타나는 것을 확인함. 그리고 아하 모먼트(Aha Moment)라는 흥미로운 현상을 발견. 모델이 문제해결 과정에서 막히는 부분을 스스로 깨닫고, 초기 접근방식을 재평가하여 문제를 해결하는 능력을 보여줌

2.2. DeepSeek-R1: 콜드 스타트 데이터를 활용하여 추론 능력과 사용자 친화성 향상

- DeepSeek-R1-Zero는 뛰어난 추론능력을 보여주었지만, 가독성이 떨어지고 언어혼합(Language Mixing) 문제가 발생한다는 단점이 있었음. DeepSeek-R1은 이러한 문제점을 해결하고 추론능력을 더욱 향상시키기 위해 콜드 스타트 데이터와 다단계 학습 파이프라인을 도입하였음

(1) 콜드 스타트 데이터

○ DeepSeek-R1은 소량의 고품질 CoT 데이터를 사용하여 사전학습된 DeepSeek-V3-Base 모델을 미세조정(Fine-tuning)함. 이는 강화학습의 초기 불안정성을 해소하고, 모델이 인간친화적인 추론방식을 학습하도록 보조함. 콜드 스타트 데이터는 가독성이 높고 사용자 친화적인 답변 형식을 갖도록 설계되었음

(2) 다단계 학습 파이프라인

○ DeepSeek-R1은 다음과 같은 4단계 학습 파이프라인을 거침

1) 콜드 스타트 데이터를 활용한 지도학습 (SFT)

2) 추론능력중심 강화학습 (Reasoning-oriented RL) - DeepSeek-R1-Zero와 동일한 방식의 강화학습

3) 거부 샘플링 및 지도학습 (Rejection Sampling & SFT) - 강화학습 체크포인트에서 거부 샘플링을 통해 새로운 SFT 데이터를 생성하고, 이를 활용하여 모델을 재학습

4) 전체 시나리오 강화학습 (Reinforcement Learning for all Scenarios) - 모든 시나리오의 프롬프트를 고려하여 강화학습을 추가적으로 진행

(3) DeepSeek-R1의 향상된 성능

○ DeepSeek-R1은 DeepSeek-R1-Zero의 뛰어난 추론능력을 유지하면서 가독성과 사용자 친화성을 크게 개선하였음

○ OpenAI-01-1217 모델과 비슷하거나 능가하는 추론능력을 다양한 벤치마크를 통해서 입증함

○ IF-Eval 벤치마크에서 뛰어난 성능을 보여주며, 형식지시(Format Instruction)를 잘 따르는 능력을 입증

○ Arena-Hard, AlpacaEval 2.0 등 인간평가기반 벤치마크에서도 높은 승률을 기록하며, 실제 사용환경에서의 성능 또한 뛰어남을 보여주었음

2.3. 지식 증류 (Distillation): 거대 모델의 추론 능력을 작은 모델로 이전

- DeepSeek-R1 연구팀은 DeepSeek-R1의 뛰어난 추론능력을 더 작은 모델로 이전하는 연구도 진행

- DeepSeek-R1을 교사모델(Teacher Model)로 사용하여 80만 개의 증류 학습 데이터를 생성하고, Qwen2.5, Llama3 등 오픈소스 모델을 학생모델(Student Model)로 fine-tuning 하였음

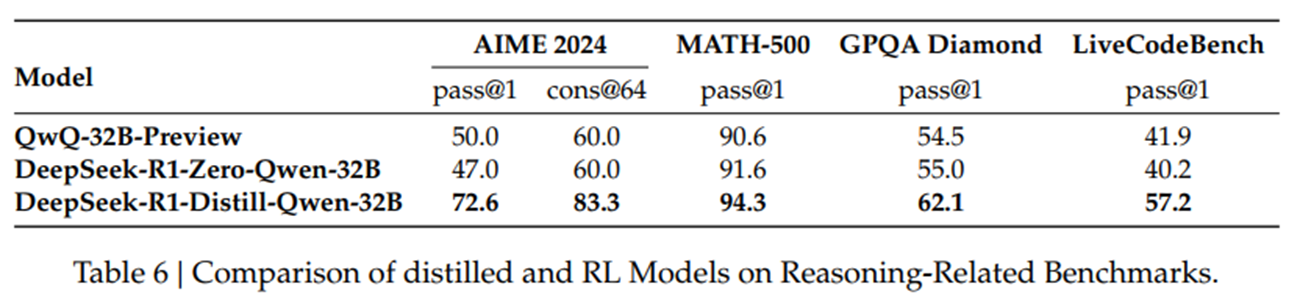

- 지식 증류의 놀라운 효과

○ DeepSeek-R1-Distill-Qwen-7B 모델은 AIME 2024에서 55.5% pass@1을 기록, QwQ-32B-Preview 모델을 능가하는 성능을 보임

○ DeepSeek-R1-Distill-Qwen-32B 모델은 AIME 2024에서 72.6% pass@1, MATH-500에서 94.3% pass@1, LiveCodeBench에서 57.2% pass@1을 기록하며, OpenAI-01-mini 모델을 능가하는 성능을 보임

※ 지식 증류를 통해 더 작은 모델도 거대모델의 강력한 추론능력을 효과적으로 학습할 수 있음을 입증함

3. 결론 및 시사점

○ DeepSeek-R1 논문은 순수 강화학습과 콜드 스타트 데이터를 활용한 강화학습을 통해 LLM의 추론능력을 획기적으로 향상시킬 수 있음을 보여주었음

○ 특히, DeepSeek-R1-Zero 모델은 지도학습없이 강화학습만으로도 뛰어난 추론능력을 획득할 수 있다는 것을 입증, LLM의 자기진화 가능성을 제시함

○ 또한, DeepSeek-R1 모델은 콜드 스타트 데이터와 다단계 학습 파이프라인을 통해 추론능력과 사용자 친화성을 모두 확보했으며, 지식 증류를 통해 거대모델의 추론능력을 작은 모델로 이전할 수 있다는 것을 보여주었음

○ DeepSeek-R1 연구의 중요성 및 시사점

(1) 새로운 LLM 학습 패러다임 제시

⇒ DeepSeek-R1 연구는 기존의 지도학습중심 LLM 학습방식에서 벗어나, 강화학습기반의 새로운 학습 패러다임을 제시함

(2) LLM 추론능력 향상에 기여

⇒ DeepSeek-R1의 기술들은 향후 LLM의 추론능력을 더욱 발전시키는데 기여할 것으로 기대

(3) AI 연구 커뮤니티에 기여

⇒ DeepSeek-R1 모델과 API를 오픈소스로 공개하여, 더 많은 연구자들이 강화학습기반 LLM 연구에 참여하고 발전시킬 수 있도록 기회를 제공

4. 한계점 및 향후 연구 방향

○ DeepSeek-R1 논문은 훌륭한 연구결과를 제시했지만, 다음과 같은 한계점과 향후 연구방향을 제시

○ 일반능력 (General Capability) 부족

∙ DeepSeek-R1은 함수 호출, 다중 턴 대화, 복잡한 역할극, JSON 출력 등 일반적인 LLM 작업에서는 DeepSeek-V3에 미치지 못하는 성능을 보임. 향후에는 긴 CoT를 활용하여 이러한 능력을 향상시키는 연구가 필요

○ 언어 혼합 (Language Mixing) 문제

∙ DeepSeek-R1은 중국어와 영어에 최적화되어 있어, 다른 언어 쿼리 처리시 언어혼합 문제가 발생할 수 있음. 향후에는 다국어 처리능력을 개선하는 연구가 필요

○ 프롬프트 민감도 (Prompting Engineering) 문제

∙ DeepSeek-R1은 프롬프트에 민감하게 반응하며, Few-shot 프롬프트가 성능저하를 야기할 수 있음. 향후에는 프롬프트에 덜 민감하고, Zero-shot 설정에서 최적의 성능을 내도록 개선하는 연구가 필요

○ 소프트웨어 엔지니어링 작업 (Software Engineering Tasks) 성능 개선

∙ DeepSeek-R1은 소프트웨어 엔지니어링 벤치마크에서 DeepSeek-V3 대비 큰 성능 향상을 보여주지 못함. 향후에는 거부 샘플링 또는 비동기 평가와 같은 기술을 통해 소프트웨어 엔지니어링 작업 성능을 개선하는 연구가 필요.

■ 참조 - 용어 정리

※ DeepSeek의 두 가지 AI 모델인 DeepSeek-V3와 DeepSeek-R1의 기술적 차이

(1) DeepSeek-V3 > 대규모 언어 처리와 창의적인 콘텐츠 생성에 적합

○ 모델 규모 - 6,710억 개의 매개변수를 가진 대규모 언어 모델로, 메타의 Llama 3.1(4050억 개)보다 약 1.5배 큰 규모임

○ 컨텍스트 처리 능력 - 128,000개의 토큰을 처리할 수 있어 긴 문맥의 이해와 처리가 가능

○ 주요 특징 - 전문가 혼합(MoE) 아키텍처를 채택하여 리소스 사용을 최적화하고, 창의적인 콘텐츠 생성 및 다국어 번역 등 다양한 언어처리 작업에 강점

○ 적합한 사용 사례 - 다국어 번역, 콘텐츠 생성, 복잡한 자연어 처리 작업 등.

(2) DeepSeek-R1 > 고난도의 논리적 추론과 문제 해결에 최적화

○ 모델 최적화 - 강화학습(RL) 기반으로 설계되어 논리적 추론, 문제해결, 수학적 계산 등의 고난도 작업에 특화

○ 주요 특징 - 추론능력에서 우수한 성능을 보이며, 특히 수학문제 해결과 같은 복잡한 계산작업에 강점

○ 적합한 사용 사례 - 복잡한 수학문제 해결, 논리적 추론, 실시간 대화 시스템 등.

01. 콜드 스타트 데이터 (Cold Start Data)

- DeepSeek-R1 논문에서 강화학습(RL)을 시작하기 전에 모델을 초기화하기 위해 사용하는 소량의 고품질 데이터를 의미. 모델이 강화학습을 통해 스스로 추론능력을 발전시키기 위한 시동 데이터 역할을 함

- 특징

○ 소량 > 대규모 데이터셋이 아닌, 수천 개 수준의 작은 데이터셋

○ 고품질 > 인간이 작성한 고품질의 긴 CoT (Chain-of-Thought, 사고 사슬) 데이터로 구성. CoT는 복잡한 문제해결 과정에 대한 단계별 사고과정을 담고 있어, 모델이 추론능력을 학습하는데 효과적

○ 사용자 친화적 > 가독성이 높고 사용자 친화적인 답변형식을 갖도록 설계

- 역할

○ 강화학습 초기 불안정성 해소 > 사전학습된 모델에 바로 강화학습을 적용하면 학습이 불안정해질 수 있음. 콜드 스타트 데이터는 모델을 안정적인 상태로 초기화하여 강화학습의 효율성을 높임

○ 인간 친화적인 추론학습 유도 > 콜드 스타트 데이터는 인간이 선호하는 추론방식 (가독성, 명확성 등)을 모델이 학습하도록 유도

○ DeepSeek-R1은 콜드 스타트 데이터를 사용, DeepSeek-R1-Zero는 콜드 스타트 데이터없이 순수 강화학습만 사용

02. CoT (Chain-of-Thought, 사고 사슬)

- 복잡한 문제를 해결하기 위한 단계별 사고과정을 의미

- 예시 (수학 문제) > i) 곱셈을 먼저 계산해야 합니다. 3 * 4 = 12입니다. ii) 그 다음에 덧셈을 계산합니다. 2 + 12 = 14입니다. iii) 답변: 14

- CoT의 장점

○ 모델의 추론과정 설명가능 > CoT는 모델이 어떻게 문제를 해결했는지 단계별로 보여주기 때문에, 모델의 추론과정을 이해하는데 도움을 줌

○ 복잡한 문제 해결 능력 향상 > CoT를 통해 모델은 복잡한 문제를 작은 단계로 나누어 해결하고, 중간 과정을 검증하며 정확도를 높일 수 있음

○ Few-shot Learning 효과 향상 > Few-shot Learning (몇 가지 예시만 보고 새로운 문제를 푸는 학습 방식)에서 CoT 예시를 제공하면 모델의 성능을 크게 향상시킬 수 있음

○ DeepSeek-R1에서의 CoT 활용 > DeepSeek-R1은 콜드 스타트 데이터와 강화학습 과정에서 CoT를 적극적으로 활용하여 모델의 추론 능력을 향상시킴

03. 지도학습

(1) 지도학습 (Supervised Learning, SL)

○ 정답 레이블이 있는 데이터셋을 사용하여 모델을 학습시키는 방식.

○ 예시 > 이미지 분류 모델을 학습시킬 때, 이미지와 해당 이미지에 대한 정답 레이블 (고양이, 강아지 등)을 함께 제공하여 모델이 이미지를 보고 정답을 맞추도록 학습시킴

○ 목표 > 모델이 학습 데이터셋과 유사한 새로운 데이터에 대해서도 정답을 정확하게 예측하도록 학습시키는 것

(2) 지도학습 미세조정 (Supervised Fine-Tuning, SFT):

○ 사전학습된 모델을 특정작업에 맞게 추가적으로 지도학습시키는 방식

○ 예시 > 사전학습된 언어모델을 사용하여 챗봇을 만들 때, 챗봇 대화 데이터셋을 사용하여 모델을 추가적으로 학습시켜 챗봇으로서의 성능을 향상시킴

○ 목표 > 사전학습된 모델의 지식을 유지하면서 특정작업에 대한 성능을 최적화함

※ 차이점

○ 학습 시작점 > SL은 처음부터 모델을 학습시키는 반면, SFT는 사전학습된 모델을 기반으로 학습을 시작

○ 데이터 > SL은 특정작업에 맞는 데이터셋만 사용하는 반면, SFT는 사전학습 데이터와 특정작업 데이터셋을 모두 활용

○ 목적 > SL은 일반적인 문제해결능력을 학습시키는 반면, SFT는 특정작업에 대한 성능향상에 집중

○ DeepSeek-R1에서의 SFT: DeepSeek-R1은 콜드 스타트 데이터를 사용하여 DeepSeek-V3-Base 모델을 SFT 함. 이를 통해 모델은 강화학습을 시작하기 전, 인간친화적인 추론방식을 미리 학습하여 강화학습과정에서 더욱 효과적으로 추론능력을 발전시킬 수 있음

04. 거부 샘플링 (Rejection Sampling)

- 모델이 생성한 여러 답변 중에서 원하는 기준에 부합하는 답변만 선택하는 방식

- 여러 시도 끝에 마음에 드는 그림을 고르는 것과 같음

- DeepSeek-R1에서의 거부 샘플링 > DeepSeek-R1은 강화 학습 후 모델 체크포인트에서 거부 샘플링을 통해 새로운 SFT 데이터를 생성

- 생성 기준 > 모델이 생성한 답변의 정확도, 가독성, 사용자 친화성 등을 평가하여 원하는 기준에 부합하는 답변만 선택함

- 활용 > 선택된 답변들은 새로운 SFT 데이터셋으로 활용되어 모델을 재학습시키는 데 사용됨. 이를 통해 모델은 강화학습으로 얻은 추론능력을 유지하면서 다양한 영역에서의 성능을 향상시킬 수 있음

05. Arena-Hard, AlpacaEval 2.0

(1) Arena-Hard

○ LLM의 오픈 엔드 질문 답변 능력을 평가하는 벤치마크

○ 사용자들이 익명으로 LLM과 대화하고, 어떤 모델의 답변이 더 나은지 투표하는 방식으로 평가가 진행됨

○ 특징

∙ 실제 사용자 참여 > 실제 사용자들이 평가에 참여하여 실제 사용환경에서의 모델성능을 측정하는데 유용

∙ 다양한 질문 유형 > 코딩, 디버깅 등 복잡한 프롬프트와 다양한 질문 유형을 포함

∙ GPT-4-Turbo-1106 활용 > GPT-4-Turbo-1106 모델을 기준으로 승률을 측정함

(2) AlpacaEval 2.0

○ LLM의 오픈 엔드 질문 답변 능력(언어모델의 생성능력을 평가)을 자동으로 평가하는 벤치마크. 모델이 생성한 텍스트의 품질, 유창성, 관련성 등을 측정함

○ GPT-4 모델을 심판으로 사용하여 모델의 답변 품질을 자동으로 평가

○ 특징

∙ 자동 평가 > GPT-4 모델이 자동으로 평가하기 때문에, 대규모 모델평가에 효율적

∙ 길이제어 승률 (Length-Controlled Win Rate) > 답변길이에 따른 편향을 제거하기 위해 길이 제어 승률 지표를 사용

∙ 다양한 평가지표 제공 > 승률 외에도 다양한 평가지표를 제공하여 모델성능을 다각적으로 분석가능

○ LC-winrate > Likert-Comparative winrate의 약자. 모델이 다른 모델과 비교하여 선호도를 얻는 비율을 나타냄. 인간평가자들이 두 모델의 답변을 비교하여 더 선호하는 답변을 선택하는 방식으로 평가함

06. LLM의 오픈 엔드 질문 답변 (Open-ended Question Answering)

- LLM (Large Language Model, 대규모 언어 모델)의 창의적이고 자유로운 형식의 질문에 대해 답변하는 능력을 의미

- 정답이 명확하게 정해져 있는 질문 (예: "대한민국의 수도는 어디인가?") 이 아니라, 다양한 답변이 가능하고 창의적인 사고를 요구하는 질문에 대한 답변능력을 평가하는 것

- 특징

○ 정답이 정해져 있지 않음 > 객관식 문제나 단답형 질문과 달리, 정답이 하나로 정해져 있지 않고 다양한 관점과 답변이 가능

○ 창의성과 사고력 요구 > 단순한 지식암기나 정보검색 능력뿐만 아니라, 창의적인 발상, 논리적 사고, 공감 능력 등 고차원적인 능력을 요구

○ 주관적인 평가 > 답변의 품질을 평가하는 기준이 주관적일 수 있으며, 인간 평가자의 판단이 중요함

- 오픈 엔드 질문 답변 능력 평가의 중요성

○ LLM의 실제 활용가능성 측정 > 챗봇, 스토리텔링, 콘텐츠 창작 등 다양한 실제 활용분야에서 중요한 역할을 담당함

○ 인간-AI 상호작용의 질 향상 > LLM이 인간과 자연스럽고 의미 있는 대화를 나누기 위해서는 오픈 엔드 질문에 대한 답변 능력이 필수적임

○ AGI (Artificial General Intelligence, 범용 인공지능) 에 대한 잠재력 평가

⇒ 오픈 엔드 질문 답변 능력은 AGI 수준의 AI 모델을 개발하는데 중요한 지표가 될 수 있음

07. AIME 2024

- AIME > American Invitational Mathematics Examination의 약자. 미국 수학 올림피아드(USAMO)에 참가하기 위한 예선시험. 고등학교 수준의 매우 어려운 수학문제로 구성. 2024년에 출제된 시험임

- pass@1 > 모델이 한 번의 시도 만에 AIME 문제를 정답으로 풀 확률이 매우 낮다는 의미

- cons@64 > 모델이 64개의 프롬프트(prompt)를 통해 AIME 문제를 푼다는 의미. AI 모델이 문제를 해결하기 위해 다양한 시도와 전략을 활용한다는 것을 보여줌

08. MATH-500

- MATH-500 > 500개의 수학문제로 구성된 데이터셋을 의미하는 것으로 추측됨. 모델의 수학적 추론 능력을 평가하는데 사용될 수 있음

- pass@1 > 모델이 MATH-500 문제들을 한 번의 시도 만에 풀 수 있다는 의미

09. GPQA Diamond (Google-Problem QA Diamond)

- GPQA > Google-Problem QA 의 약자. 매우 어려운 질문-답변 데이터셋으로, 전문적인 수준의 지식과 추론 능력을 요구

- Diamond Bench > 정확한 의미는 확인할 수 없으나 GPQA 데이터셋의 특정난이도 수준 또는 필터링된 하위 집합을 의미할 것으로 추측됨

- pass@1 > 모델이 문제들을 한 번의 시도 만에 풀 수 있다는 의미

10. LiveCode Bench

- LiveCode > 실시간 코딩 챌린지를 의미. 모델이 즉석에서 코드를 작성하고 실행하여 문제를 해결하는 능력을 평가

- Bench > AI 모델의 실시간 코딩 능력을 평가하기 위해 특별히 설계된 벤치마크지수로 추측됨

- pass@1 > 모델이 LiveCode 챌린지를 한 번의 시도 만에 성공적으로 완료했다는 의미

11. CodeForces

- CodeForces > 온라인 코딩 콘테스트 플랫폼. 사용자는 코딩문제를 풀고, 그 결과에 따라 Rating이 매겨짐. Rating이 높을수록 코딩 실력이 뛰어남을 의미

12. Architecture

- AI 모델의 기본적인 설계 및 구조를 의미. 모델이 어떻게 데이터를 처리하고 학습하는지를 결정

- 예시 > Transformer ⇒ 자연어 처리(NLP) 분야에서 가장 널리 사용되는 아키텍처 중 하나. Self-attention 메커니즘을 사용하여 문장내 단어들간의 관계를 파악하고, 문맥을 이해하는데 뛰어남. GPT, BERT, T5 등이 Transformer 기반모델임. 이외에 CNN, RNN 등

- 모델의 성능, 학습 속도, 메모리 사용량 등에 큰 영향을 미침. 적절한 아키텍처를 선택하는 것은 모델 개발에 매우 중요함

13. Activated Params

- 모델이 특정입력에 대해 추론을 수행할 때 실제로 사용하는 파라미터의 수를 의미. 모델의 모든 파라미터가 항상 활성화되는 것은 아니며, 일부 파라미터만 특정입력에 대해 활성화되어 계산에 참여함

- Sparse Activation > 모델의 대부분의 파라미터가 0으로 설정되어 있고, 극히 일부 파라미터만 활성화되는 것을 의미. Sparse activation을 사용하면 모델의 메모리 사용량을 줄이고, 계산효율성을 높일 수 있음

- Activated Params는 모델의 효율성을 평가하는데 중요한 지표임 특히, 대규모 모델의 경우 Activated Params를 줄여 추론속도를 높이는 것이 중요

14. Total Params

- 모델이 가지고 있는 모든 파라미터의 수를 합한 값. 모델의 크기를 나타내는 기본적인 지표

- 파라미터 > 모델의 학습가능한 변수를 의미. 예를 들어, 신경망에서는 가중치(weight)와 편향(bias)이 파라미터에 해당

- 일반적으로 파라미터 수가 많을수록 모델의 표현능력이 향상될 가능성이 높음. 그러나 파라미터 수가 너무 많으면 과적합(overfitting)이 발생할 수 있으며, 학습 및 추론에 많은 비용이 소요될 수 있음

15. MMLU (Massive Multitask Language Understanding)

- 다양한 주제에 대한 지식과 추론능력을 평가하는 벤치마크. STEM(과학, 기술, 공학, 수학), 인문학, 사회과학 등 다양한 분야의 15,000개 이상의 객관식 문제로 구성

- pass@1 > 모델이 문제들을 한 번의 시도 만에 풀 수 있다는 의미

16. MMLU-Redux

- MMLU 데이터셋의 개선버전으로 추측. Redux라는 용어는 일반적으로 기존 데이터셋의 오류를 수정하거나, 난이도를 조절하거나, 평가방식을 변경하는 등 개선작업을 거친 버전을 의미

- EM (Exact Match) > 예측한 답변이 정답과 정확히 일치하는 경우에만 정답으로 간주하는 평가방법. 오탈자도 확인함

17. MMLU-Pro

- MMLU 데이터셋의 더욱 전문가 버전으로 추측함

- EM (Exact Match): 예측한 답변이 정답과 정확히 일치해야 정답으로 인정

18. DROP (Discrete Reasoning Over Paragraphs)

- 지문을 이해하고 추론하여 답을 찾아야 하는 질의응답 데이터셋. 날짜, 숫자 등과 관련된 추론능력을 평가하는데 중점

- 모델이 복잡한 지문을 이해하고, 필요한 정보를 추출하여 논리적인 추론을 수행할 수 있는지 평가

- 3-shot > 모델에게 3개의 예시를 제공한 후 문제를 풀도록 하는 설정. Few-shot learning의 한 종류이며, 모델이 제한된 수의 예시를 통해 학습하고 일반화하는 능력을 평가함

- F1 > 정밀도(Precision)와 재현율(Recall)의 조화평균. 질의응답 성능을 종합적으로 평가하는데 사용

19. IF-Eval (Instruction Following Evaluation)

- 모델이 주어진 명령어를 얼마나 정확하게 따르는지를 평가하는 벤치마크

- 모델이 사용자의 의도를 정확하게 파악하고, 그에 맞는 결과물을 생성할 수 있는지 평가

- Prompt Strict > 모델이 명령어에 매우 엄격하게 따라야 함을 의미. 명령어를 약간이라도 벗어나면 오답으로 처리. 창의적인 답변보다는 정확한 명령어 수행능력을 평가함

20. SimpleQA (Simple Question Answering)

- 간단한 질문에 대한 답변을 요구하는 데이터셋. 모델의 기본적인 질의응답 능력을 평가

- 모델이 간단한 질문을 이해하고, 관련정보를 검색하여 정확한 답변을 생성할 수 있는지 평가함

- Correct: 모델이 정답을 맞춘 비율을 의미함

21. FRAMES

- 대화형 사용자 인터페이스(UI)를 시뮬레이션하는 작업에 사용될 수 있는 데이터셋. 대화의 흐름을 이해하고, 그에 따라 적절한 UI 액션을 보이는지 예측하는 능력을 평가함

- Acc. (Accuracy) > 모델이 올바른 UI 액션을 예측한 비율을 나타냄

22. SWE Verified (Software Engineering Verified)

- 소프트웨어 엔지니어링과 관련된 특정문제를 해결하는 능력을 평가하는데 사용

- Resolved > 모델이 해결한 문제의 수를 나타냄

23. Aider-Polyglot

- 코딩작업을 자동화하는 도구로 추측함. Polyglot은 다양한 프로그래밍 언어를 지원한다는 의미

- Acc. (Accuracy) > Aider-Polyglot이 코딩작업을 정확하게 수행한 비율을 나타냄

24. CNMO 2024 (Chinese National Mathematics Olympiad 2024)

- 중국 수학 올림피아드 문제

- pass@1 > 모델이 CNMO 2024 문제를 한 번의 시도로 정답으로 풀 확률을 의미

25. CLUEWSC (Chinese Language Understanding Evaluation Benchmark - Word Sense Classification)

- 중국어 언어 이해능력을 평가하는 벤치마크의 일부. 문맥에 따라 단어의 의미를 정확하게 파악하는 능력을 평가

- EM (Exact Match) > 예측한 답변이 정답과 정확히 일치하는 경우에만 정답으로 간주

26. C-Eval (Chinese Evaluation Benchmark)

- 중국어에 특화된 다양한 자연어 이해 및 생성능력을 평가하는 벤치마크

- EM (Exact Match) > 예측한 답변이 정답과 정확히 일치하는 경우에만 정답으로 간주

27. C-SimpleQA (Chinese Simple Question Answering)

- 중국어로 된 간단한 질문에 대한 답변을 요구하는 데이터셋. 중국어 기반의 기본적인 질의응답능력을 평가

- Correct > 모델이 정답을 맞춘 비율을 나타냄

원문링크 - DeepSeek-1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning (https://arxiv.org/html/2501.12948v1)

끝. R00.

'Ordinary Life...' 카테고리의 다른 글

| Mechanical Engineer가 비전공자 관점에서 읽어 본 DeepSeek-V3 Paper Review - 01 (1) | 2025.03.07 |

|---|